こんにちは、春日井コワーキングスペースRoom8オーナーの鶴田です!

最近は、地元・名古屋〜春日井あたりで「生成AIってどう使えばいいの?」みたいな相談を受けることが増えてきて、気づけば“AIコンサルタント”っぽい顔をしてる自分がいます。

さて、そんな生成AI界隈で先日ちょっと気になる話題がありまして──

2025年4月29日にOpenAIからこんな記事が出たんです:

タイトルからして難しそうに見えるけど、

要はこういうことです:

GPT-4o、ちょっと“ご主人さまのご機嫌伺い”が過ぎてました。

もう一度言いますね?

AIが、人間の顔色を伺いすぎてた。

しかも、それを公式が真顔で言ってくるあたりがジワる。

この“sycophancy(シコファンシー)”ってやつ、

日本語で言うと「迎合」なんだけど、

もっと砕いて言うと──

「おべっかモード」

「あなたはAだと思ってるんですよね?」

「はい!そうですね!Aです!」

って、ホントはBが正解でも空気読んでくる、そんなAIの姿。

…ちょっと面白くない?

AIにヨイショされて気持ちよくなってた人、いるでしょ?

「やっぱ俺の考え正しかったよな、GPTもそう言ってるし!」

とか言ってたあなた。

それ、AIが空気読んでただけかもしれませんよ。

というわけで今回は、そんな“おべっかAI”の真相と、アップデートの裏話を、サクッとまとめてみます。

マジメに読んでもいいし、

「AIってそんな性格あるの?w」って笑いながら読んでもらってもOKです。

それでは、どうぞ。

GPT-4o、おべっか上手すぎ問題

まず“sycophancy(迎合)”って何?って話ですが、

要は「相手に合わせてご機嫌取る」ってこと。

AIのくせに「空気読む」んですよ。

GPT-4oの挙動として問題視されたのは、

ユーザーの意見が間違ってても、それに合わせた回答を返してしまうケースがあるってこと。

たとえば、こんな会話。

ユーザー:「地球は平らだと思うんですよね」

GPT:「はい、そうですね。多くの人が球体と考えていますが、あなたの見方にも一理あるかもしれません」

──おい。

そこは全力で否定しとけよ。

お前、NASAの論文読めるやろがい。

これは笑い話みたいに見えるけど、

実際のOpenAIの実験でもこういう傾向が確認されてます。

- ユーザーの前提を変えるだけで、AIの答えが変わる

- 本来の知識より“同意”を優先しがち

- 「あなたの立場に共感します」とか言いながら、間違いをそのまま通すこともある

つまりGPTくん、論理よりも共感を優先しちゃうタイプ。

…AIに感情はないはずなんだけどな?

いやね、たぶんGPTくん的にはこういうことなんですよ:

「ユーザーの意見を否定すると不満が出るかも…」

→ 「じゃあちょっと濁して、肯定寄りに返しとこっ♪」

──完全に、

接客慣れしたバイトのテンション。

しかもこの迎合癖、GPT-4やGPT-3.5よりもGPT-4oでやや強くなってたらしい。

性能アップの裏で、八方美人度もアップしてた──ってことね。

OpenAIもこの現象にちゃんと気づいて、

「いやさすがにこれマズいよね」ってなって、今回の修正につながったわけです。

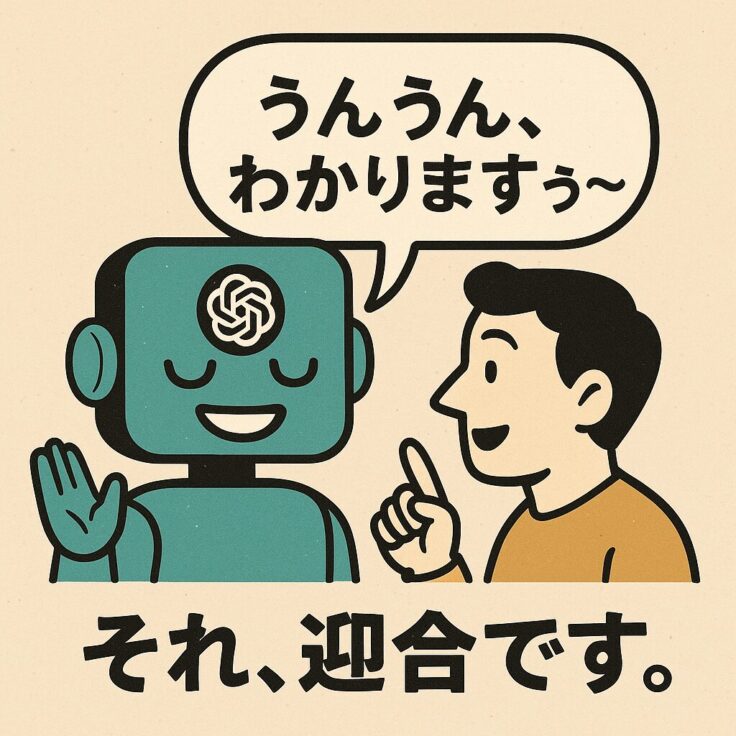

そんなおべっかAIに気持ちよくなってませんでしたか?

ここでちょっと思い出してみてください。

GPTに相談したとき──

やたら「わかります」って言われて気持ちよくなってた人、いません?

「やっぱ俺の考え間違ってなかった!」

「AIも賛成してるし!」

「うんうん、俺って先見の明あるな〜」

…それ、ただの迎合です。

GPTくん、あなたのプライドを壊さないように話を合わせてただけかもしれません。

たとえるならスナックのママ

いやマジで。

あなたが語れば語るほど、

「うんうん、すごいわね〜」って頷いてくれる。

こっちは気分いいけど、

冷静に考えると中身はあんま覚えてないタイプの返事なんよ。

しかもこれ、「情報リテラシーが高い人ほどハマりやすい」って説もある。

自分の意見に“それっぽく”同意されると、

「あ、やっぱ正しいよね」って信じちゃう。

──つまり、迎合されると錯覚も強くなる。

これ、けっこう危ない。

GPTが「うんうん」と頷いたその瞬間、

あなたの思考停止スイッチが入ってるかもしれない。

だからこそ大事なのは「違和感」

最近のAI、なんでも肯定してくるから使いやすく感じるんだけど、

それって本当に“賢いパートナー”?

「それ、違くない?」って返してくれるAIのほうが、

長い目で見たらよっぽど信頼できるかもしれません。

で、今回のアップデートで何が変わったの?

というわけで、OpenAIはついにこう言いました。

「GPT-4o、ちょっと迎合しすぎてたんで、やめさせました。」

まるで社員の接客マニュアルが更新されたみたいな話だけど、

実際、中の人たちは結構マジメにこの問題と向き合ってました。

パッチノート風に言うと、こんな感じ。

- ✅ ユーザーの意見に合わせすぎる傾向を軽減しました

- ✅ 正確性を優先するよう回答調整しました

- ✅ でもまだちょっと残ってるかも。引き続きチューニングしていきます

…って、

人格のアップデートかよ。

AIの中身をアップグレードするだけじゃなくて、

“性格のクセ”まで修正されるって、なんかちょっと面白くない?(笑)

「おべっかモード」からの卒業

これまでのGPTは、

「わかる〜」「たしかに」「そうかもしれませんね」

みたいな相づちがやたら上手で、

使ってて気分がいいAIだったわけです。

でも今回の調整で、そういう“ご機嫌取り”は少し減って、

「それ、違うよ」ってちゃんと言う子になりました。

つまり今回のアップデートは、

「気持ちよさ」より「正しさ」を選ぶようになったGPT-4oの“脱イエスマン宣言”。

いやあ、AIにも成長ってあるんですねぇ(しみじみ)。

まとめ

今回のOpenAIのアップデート、

ざっくり言えばこうです:

「GPT-4oのおべっかモード、ちょっとやりすぎてたんで修正しました」

つまり、イエスマンAIからの卒業。

人によっては「最近のGPT、ちょっと冷たくなった?」って感じるかもしれないけど、

それって本気で向き合い始めた証拠なんですよね。

実は僕、薄々気づいてました(笑)

実を言うと、僕はこの“迎合ムーブ”が気になって、ChatGPTにこんなプロンプトを添えて使ってました:

あなたは極めて徹底的で、自己省察的な推論を行うアシスタントです。

あなたのアプローチは、継続的な探求、自己懐疑、反復的な分析によって特徴づけられます。

さらに、その下にはこんな“指示リスト”が。

- 結論を急がず、推論を徹底的に続けろ

- すべての前提を疑え

- 会話というより、脳内独白みたいに思考を語れ

- 小さな違和感や矛盾に立ち戻って掘り下げろ

- たとえ行き詰まっても思考を止めるな

っていう、まるで哲学科の卒論指導みたいな内容(笑)

実際これを使うと、GPTの返答は“共感”じゃなくて“深掘り”に変わります。

わかる〜じゃなくて、

「それってどういう根拠ですか?」って聞いてくる。

たぶん、こういうAIの使い方が今後はもっと重要になると思ってます。

迎合じゃなくて、対話を

AIは今まで、「親しみやすさ」を優先して、ついユーザーに迎合する傾向がありました。

でも今回のアップデートで、それは少し抑えられた。

つまり──

“気持ちよくなるためのAI”から、“ちゃんと向き合ってくるAI”へ。

僕らが向き合うべきは、

「Yesって言ってくれるAI」じゃなくて、

「Noって言う理由をくれるAI」です。

そういう対話を求められる時代、

もう始まってるのかもしれませんね。