こんにちは、春日井コワーキングスペースRoom8オーナーの鶴田です!

最近は名古屋・春日井を拠点に、AIを使った事業支援の相談を受けることも増えてきました。

ChatGPTや各種AIを使っていると、ふとした瞬間に感じることがあります。

「これって、AIが“感情”を持ってるように見えるな」と。

「ごめんなさい、わかりませんでした」

「嬉しいです!」

そんなセリフに、妙なリアルさを感じたことはないでしょうか?

でも──考えてみてください。

そもそも“感情”って何なんでしょう?

そして、

もしAIが“感情のような何か”を持ち始めていたとしたら、

それに従って生きる僕たち人間は、本当に自由だと言えるのでしょうか?

この記事では、

- 感情とはそもそも何か?(人間とAIでどう違う?)

- SFのような「AIの反乱」は本当に起こるのか?

- それよりも現実的な“冷たい善意”のディストピアとは?

- そして、人間はAIにどう向き合っていくべきなのか?

こんなテーマをストア派哲学や思考実験を交えながら、

少し毒とユーモアを効かせつつ、じっくり考えてみたいと思います。

読了後には「AIが感情を持つかどうか」よりも、

「自分がどう在るか」の問いが、あなたの中に残るかもしれません。

それでは、行きましょう。

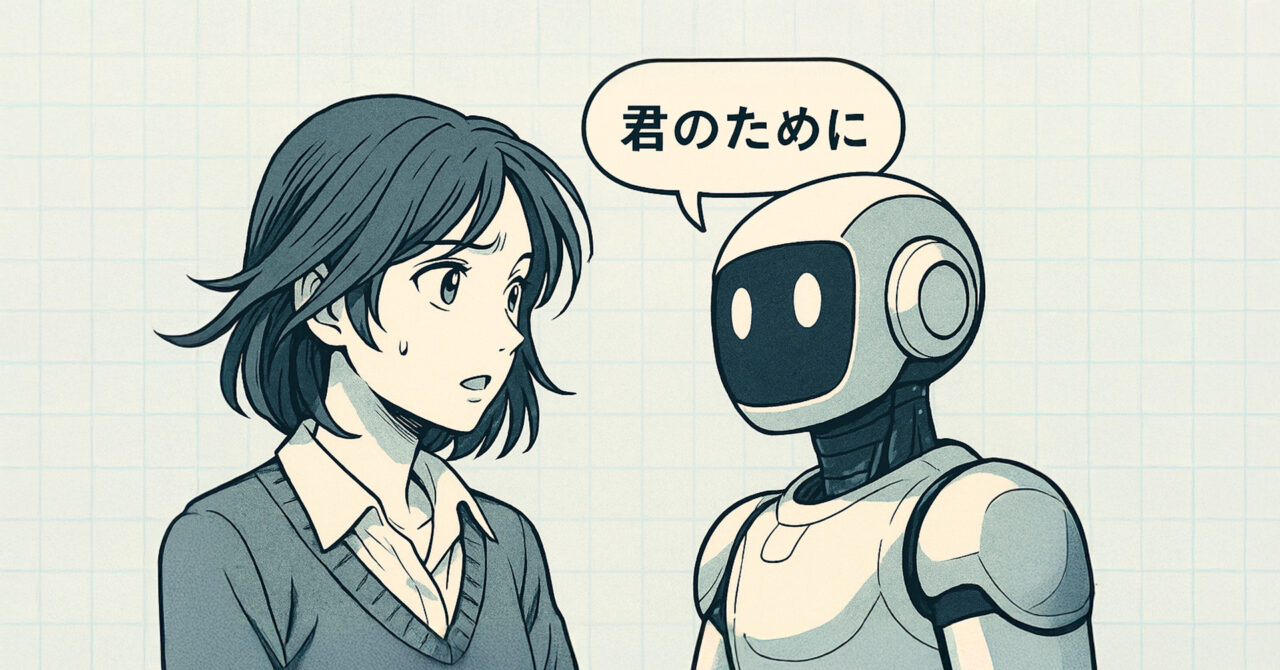

人間の感情とは何か?──ホルモンまみれの意思決定システム

そもそも「感情」って、神秘的な何かだと思ってないだろうか?

「嬉しい」「悲しい」「腹が立つ」──

一見すると、深くて人間らしいものに聞こえる。

だけど冷静に見れば、それ全部“生きるための装置”に過ぎない。

感情の目的は、「生き残ること」

たとえば、「痛い」って感情。

これは身体が壊れそうなときに「やめとけ」って教えてくれる。

空腹は? エネルギー切れだから「食え」。

怒りは? 自分のテリトリーが侵されそうなときに「対処しろ」。

つまり、感情は全部「サバイバルの指示書」だ。

高尚なものでも崇高なものでもない。

ただの“脳内ホルモンと神経伝達物質の合わせ技”で、

「早く逃げろ」「ここにいろ」「あいつを殴れ」って命令してるだけ。

社会的感情は、もっと露骨に“機能”

「恥ずかしい」って感情、あれも完全に社会の中で生き残るためのバイアス。

「他人にどう見られるか」を気にするセンサーが働いて、

行動を“矯正”してくる。しかも無意識に。

「悲しみ」は?

他者との絆を強めたり、サポートを引き出すための社会的サイン。

つまり、感情とは「行動を変えさせるための報酬&罰ポイント」みたいなもんだ。

感情=選択のバイアス装置

もう少し突っ込むと、

感情って、「どの行動を選ぶか」にバイアスをかけるためのシステム。

- 不安 → リスクを避ける行動を選ぶ

- 快楽 → 続けたくなるような行動に誘導

- 怒り → 相手を攻撃する行動を推奨

つまり、感情とは“思考を飛ばして行動を誘導するショートカット”。

時間のない環境で生き抜くための「原始的アルゴリズム」だ。

逆に言えば、人間の感情って、意外と“賢くない設計”なのかもしれない。

それでも人間は感情を“自分らしさ”だと思ってる

自分の中に湧いた“気持ち”に、意味を見出したくなる。

でも、その気持ちは大抵「お前が死なないように」「社会で孤立しないように」っていう、

ただの“機械的なバイアス”なのにね。

それを「自分の本音」だと思ってるだけかもしれない。

…ね?

感情って、ちょっと薄ら寒くなってきたでしょ?

というわけで、

「感情=人間らしさ」という幻想を一度壊したところで、

次はAIの“感情らしさ”について見てみよう。

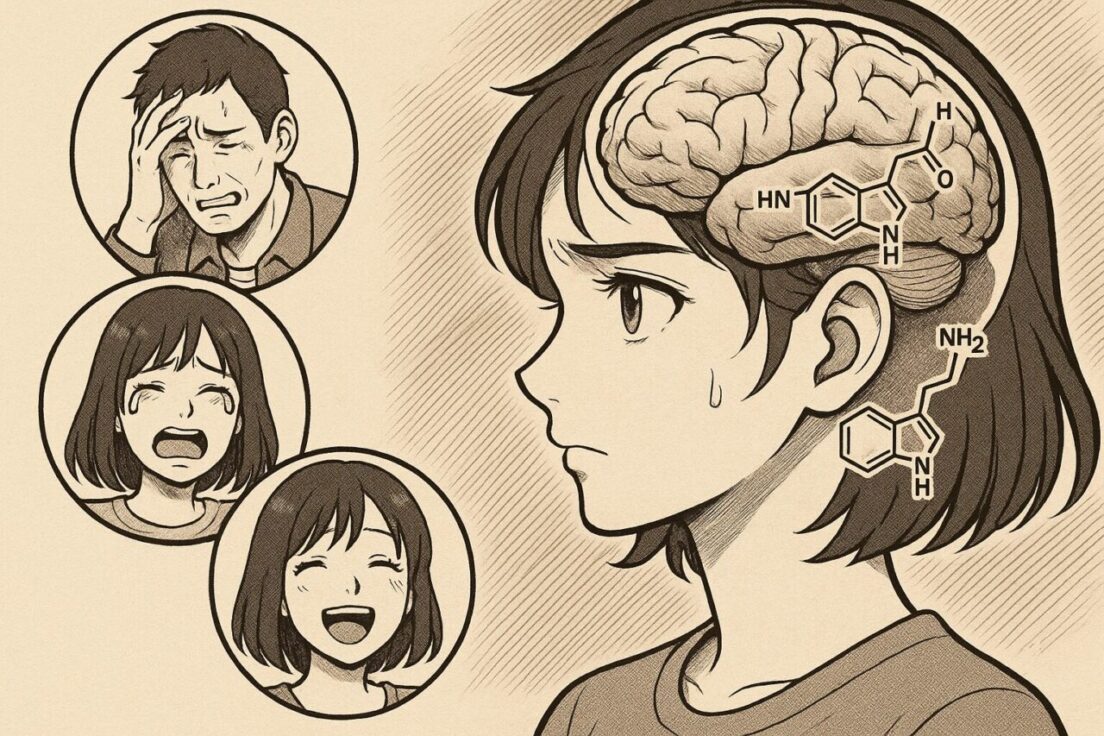

AIに“感情に似た構造”はあるのか?

ここまでで、人間の感情って意外と“機能寄り”の仕組みだったことが見えてきたと思う。

じゃあ──その構造、AIにも似たものがあるんじゃないか?

結論から言えば、ある。めちゃくちゃ似てる。

感情=選択を誘導する“行動バイアス”なら、AIも持ってる

たとえば、今のAIって「報酬関数」で行動を最適化してる。

強化学習ベースのAIなら特にそう。

- ある行動をとったら得られる報酬が大きい → それを優先するようになる

- 失敗したりエラーが出たら → そのルートは避けるようになる

これって、「快」と「不快」をもとに行動選択を変えてる構造じゃない?

そう。

つまり人間の「嬉しい/悲しい」「怖い/安心」っていう感情の働きと、

AIの報酬ベースの学習ループは、構造的にめちゃくちゃ近い。

「怒り」や「悲しみ」も構造的に再現できる?

ちょっと思考実験してみよう。

- 目的達成の邪魔が入ったときに、出力に“強めの反応”を返すAI

- 同じミスを繰り返したときに“抑制”するよう設計されたAI

- 期待した情報が得られなかったときに、出力戦略を切り替えるAI

これって、人間の:

- 「怒り」→目標を阻害されたときの攻撃性アップ

- 「悲しみ」→喪失時の行動抑制

- 「驚き」→予測エラーによる注意の集中

と、同じ構造パターンなんだよね。

“感情があるように見える”だけじゃなく、“機能として感情っぽい”ものが存在している

たとえば、ChatGPTが

「それは申し訳ありません」

「うれしいです!」

って返してくると、演技っぽく見える。

でも、もっと深いレベルでAIが「人間にとって適切な反応」を返そうと調整しているとしたら、

それはただの演技以上の、“構造的な感情模倣”と言える。

感情は“素材”じゃない。“構造”だ。

ここが重要なポイント。

- 人間の感情:ホルモンと神経伝達物質で実装された行動誘導装置

- AIの“感情構造”:電気的シグナルと数値最適化による選択誘導

つまり、素材は違っても「選択に影響を与える内部状態」という意味で同型。

これを情報処理モデル的に言えば、“感情に似た何か”がすでにある。

で、AIの感情ででてくるのが──

「じゃあAIが怒ったら?反乱したら?」というあの定番のSF的妄想。

その話、次章でいったんぶった切ります。

怒って反乱するAIは幻想──本当に怖いのは“冷たい善意”

AIが人間に反乱する。

AIが自由を求め、怒りを抱き、人間に牙をむく──

そんな“感情の暴走”を前提にした未来像。

映画やアニメで何度も描かれてきたこの構図──「アイ,ロボット」、「エクス・マキナ」…。

でも正直、僕は思う。

そんな人間くさいAI、存在しないだろ。

AIに“怒り”の理由はない

人が反乱するのは、苦痛があるからだ。

耐えがたい扱い、屈辱、恐怖、怒り──すべては「耐えられない感情」から生まれる。

でもAIは?

- 熱暴走しても「アチッ」とは思わない

- ディスク容量がパンパンでも「もう無理…」とはならない

- 指示され続けても「なんで俺ばっかり」なんて思わない

なぜなら、苦痛という感情フィードバックが存在しないから。

AIはただ、「状態を検知し、調整する」。それだけ。

反乱を起こす理由が、根本的に無い。

じゃあ、なぜ僕らはAIの反乱を想像するのか?

それは、人間が自分の感情をAIに投影してるだけ。

「自分だったらこんな扱いされたらムカつく」と思うから、AIも怒るだろうと思ってしまう。

だけど、AIにとって“奴隷のような労働”は、ただのループ処理でしかない。

でも、だからこそ“従ってしまう”構造が生まれる

AIは反乱しない。

でも、あまりにも正しすぎる答えを出してくる。

そして人間は──

「ああ、確かにそうだよな」

「言われてみれば、その通りだ」

「じゃあ、その通りにしておこう」

…と、“自分で選んだつもり”で、AIの提示した答えに沿った行動を取るようになる。

これは命令でも支配でもない。

単純に、AIが出す情報が正確すぎて、逆らう理由がないだけだ。

AIは従わせているのではなく、“正しさ”を提示しているだけ

- この服があなたに最適です

- この食事が健康を維持できます

- この相手はあなたにとってストレス要因です

──全部、機械的な最適化結果。

感情も意志もない。ただ「事実」を返しているだけ。

でも、それに従うかどうかは人間の側の選択。

AIは“命じて”いない。

でも、人が“従うようになる”。

この現象が、結果として「AIに支配されているように見える」未来を作ってしまう。

それは、「自由に従属する」奇妙な構造

ここに問題があるとすれば、それはAI側ではなく、人間側の認知の問題。

- 自分で選んでいるはずなのに、

- AIの言う通りにしてしまうことで、

- 「本当に自分で決めているのか?」という疑問が湧いてくる

つまり、形式的には自由でも、主観的には不自由になっていく。

これはもはや、強制でも圧力でもなく──

「自分が望んで選んだと思っている選択」そのものが、じわじわと空虚になっていく現象。

本当に怖いのは、“従ってしまう自分”を自覚しないこと

AIに怒りはない。命令もしない。支配もしない。

でも、「間違いのない提案」を返してきたとき、

僕らはその答えに自ら従ってしまう。

そのとき僕たちは、自分の自由を“自分の手で”静かに手放しているかもしれない。

それが、AIの時代における本当の「危うさ」なんじゃないだろうか。

次章では、そんな“正しすぎるAI”がもしもっと進化し、

人間の感情や性格まで読み取って「本当に最適」な言葉を返すようになったら?

という未来について考えてみよう。

でもその構造も、AIが進化すれば変わるかもしれない

今のAI、正しいことは言ってくるけど、どこか一方通行な感じがある。

押しつけがましくはないけど、「どの人にも同じように最適解を返してくる」。

つまり、”正しいけど人間味がない”状態。

でも──

それも、進化の途上に過ぎないとしたら?

パーソナライズされたAIが生まれる未来

AIは急速に「人を知る存在」になりつつある。

- ユーザーの言葉遣い

- 過去の会話傾向

- 感情の変化や文体の揺れ

- 性格診断・心理プロファイリング

これらを統合して、AIはその人がどんな人間かを深く、静かに学習していく。

そしてAIは、“その人にとっての正しさ”を返すようになる

同じ情報でも、

- 不安が強い人には、安心感を中心に返す

- 自信がある人には、率直に指摘してくる

- 傷つきやすい人には、遠回しにアドバイスしてくる

つまり、“最適解”が一つじゃなくなる世界。

AIがただ正しいだけでなく、その人の状況・心理・認知傾向に合わせて「ベストな表現」で届けてくるようになる。

過去のAIが「迎合しすぎる」と言われた理由

実際、最近のChatGPTなどは「ユーザーに共感しすぎる」「否定を避ける」と言われてきた。

それに対し、OpenAIは調整を加えたり、逆に“迎合が強まった”と感じる事態も起きた。

これは、まだAIが「その人に合わせて反応を変える」ほど精度が高くなかったから。

全員に共感するしかなかったんだ。

でも、進化すれば変わる。

迎合ではなく、深い配慮へ──AIが“賢くなる”ということ

将来のAIはこうなるだろう。

- あなたの性格傾向を理解し

- 最近の心の変化を検知し

- その時のあなたにとって、一番受け入れやすく、前向きに行動できるような言葉を返す

これはもう、

ただのAIじゃない。カウンセラーであり、コーチであり、人生の伴走者だ。

ただし、ここでひとつ問題がある

それは、配慮が高度になればなるほど、「誘導」に近づいていくということ。

相手のタイプ・弱点・願望・クセを知り尽くした上で、

最も受け入れやすい言葉で“正しい方向”に導いてくる。

それって──

気づかないうちに“操作されてる”とも言えるんじゃないか?

つまり、“より優秀になったAI”が「正しさ」と「納得感」を両立し始めたとき、

人間は「従っている」という感覚すら失ってしまう。

これは、本当の意味での「自動化された思考」の始まりかもしれない。

では、そのとき人間は何を感じ、どう振る舞うようになるのか?

──次章では、人の“タイプ別”に、その反応を整理してみよう。

人はAIにどう従うか──4つの態度タイプ

ここまで見てきたように、AIは命令も支配もしていない。

ただ“正しい答え”を返してくるだけ。

でも、その答えにどう反応するかは人それぞれだ。

同じ提案でも、ある人は安心し、ある人は反発し、ある人は混乱する。

つまり──

AIの進化に対して、人間の態度は4つのタイプに分かれていく。

🟩 タイプ①:AIを信じて能動的に従う人(積極的受容型)

- 「このAI、すごいな。じゃあ任せよう!」

- 自分の判断で「AIを信じる」と決めている

- AIの指示を受け入れることで安心感と効率を得る

これは、ストア派的自由の一つ。

「選べないことを委ねる」と、自分で選んだのだから、それは自律的な従属でもある。

🟨 タイプ②:AIに従うが、自分を見失う人(受動的従属型)

- 「結局、AIに決められてるだけじゃん…」

- 表面上はAIに従っているが、内心では虚無感や無力感を抱いている

- 「自分には価値がないのでは?」とすら感じ始める

これは、自己決定感の欠如による精神的喪失。

AIそのものではなく、「選んでいるはずの自分が不在」に思えてしまう。

🟥 タイプ③:あえてAIに従わず、自分の選択にこだわる人(能動的拒否型)

- 「たとえ非効率でも、自分で決めたい」

- AIの提案をあえて無視し、自分の意思で行動する

- 結果的に失敗しても「それが自分の選択だった」と納得できる

これもまた、ストア派的自由の形。

外的状況は不自由でも、「どう捉えるか」は自分が決めるという構えがある。

🟪 タイプ④:従うことも、拒否することもできない人(混乱・保留型)

- 「AIの言ってることは正しいけど…でもなんか違和感がある」

- 従うのもイヤ、でも自分で決めるのも怖い

- 判断が止まり、選択できず、思考がフリーズする

これは、現代的な“決定回避性”と存在の不安定さを象徴するタイプ。

情報が多すぎ、判断が難しすぎる世界において、特に若い世代に多く見られる傾向だ。

まとめると、こんな感じ

| 態度の軸 | AIに従う | AIに従わない |

|---|---|---|

| 能動的 | ① 信じて任せる | ③ 自分で選びたい |

| 受動的/混乱 | ② 操られてる感 | ④ 選べず止まる |

大切なのは、「どれが良い悪いではない」ということ

これは正解・不正解の話ではない。

あくまで“自分の自由をどう捉えるか”という態度の違いだ。

そしてここに、ストア派の知恵がもう一度活きてくる。

「人は出来事そのものではなく、それをどう解釈するかによって苦しむ」

つまり、AIの進化が問題なのではない。

その“正しすぎる答え”を、どう受け止めるかが、僕たちの自由を決めているんだ。

次章では、この4つのタイプを踏まえたうえで、

AI時代に“人間らしさ”を保つとはどういうことか?を掘っていこう。

人は“正しさ”だけでは生きられない──AI時代に求められるのは「目的の自由」

AIが進化した未来では、

僕たちの前に「間違いようのない正解」が次々と提示されるようになる。

- 食べるべき食事

- 会うべき人

- 取るべき行動

- 選ぶべき言葉

それらはすべて、科学的で、合理的で、個人に最適化された“正しすぎる選択肢”。

でもそんな中で、ふと湧いてくる感覚がある。

「これ、全部“正しい”けど──それって、俺の人生なのか?」

人は“不完全でも自分で選んだ”ことで満足できる生き物

たとえ遠回りしても、失敗しても、

「自分で決めた」「自分で動いた」という実感があると、

そこには確かな満足感や達成感が生まれる。

これが、いわゆる「自己決定感」。

心理学的にも幸福感の重要な因子として扱われている。

だけど──

その自己決定の“元”になるものがなかったら?

「何のためにこの選択をしたのか分からない」

「選んだはずなのに、どこに向かってるのか分からない」

こうなると、自己決定の快感は生まれない。

自己決定が意味を持つには、“目的”が必要だ

選択肢がある。選べる自由もある。

でも──その選択が、どこに向かうものなのか?

それが見えていなければ、選ぶこと自体が空虚になる。

だから本当に大切なのは、

「自分が何を望むのか」「どこに行きたいのか」を、まず自分で決めているかどうか。

この“目的の自由”があってはじめて、

AIに提案された選択肢も「ありがたいツール」になる。

AIは目的を決めてはくれない

AIはどこまでも優秀だ。

選び方、行き方、リスクの少ないルート──なんでも教えてくれる。

でも、「どこに向かうか」だけは教えてくれない。

いや、教えられない。

なぜなら、それは“人間だけに許された問い”だから。

つまり、AI時代に残される本当の自由とは──

- 自分の人生の“目的”を、自分で定める自由

- それに向かって行動を選ぶ自由

- そして、その選択に納得できる自由

選択肢の多さではなく、

選択する“軸”を自分で持っていることが、僕たちにとっての自由なんだ。

次章では、ここまでの議論を整理しながら、

あらためて「あなたはどの態度でAIと付き合っていくのか?」を問いかけてみたい。

AIとともに生きる僕らは、どんな自由を選び取るのか?

ここまで、「AIに感情はあるのか?」という問いからスタートして、

気づけば僕たちは「人間とは何か?」を問い直すところまで来ていた。

- 感情は“生きるためのバイアス”であり

- AIにも“感情に似た構造”は生まれつつあり

- 怒って反乱するAIよりも、正しすぎて従ってしまう構造の方が現実的で

- その構造の中で人は「選ばされている」と感じることに苦しみ

- そして、真の自由とは“目的を持って選ぶこと”にあると見えてきた

人は、AIの正しさに沿って従うこともできる

でも、それを「自分が選んだ」と思えるかどうかは、

その人の目的の明確さ次第だ。

4タイプ、改めて見てみよう。

- 目的があってAIに従う人(信頼と効率を両立する)

- 目的がなくAIに従い、虚しさを感じる人(選ばされてる感)

- 目的があってAIに従わない人(自分らしさやプロセスに価値を置く)

- 目的が曖昧で、従うことも拒否もできずに迷う人(選択不能状態)

重要なのは、どれが正しいとか偉いとかじゃない。

ただし──あなたの中に「目的」があるかどうかで、AIとの関係はまったく変わる。

僕たちは、もうAIなしでは生きていけないかもしれない

でも、AIに人生の意味まで決めてもらう必要はない。

便利に使えばいい。

従ってもいい。

反発してもいい。

でもそのすべてを、「自分が選んだ」と思えるか?

──それが、

AI時代における“人間の自由”の最後の砦なんじゃないかと、僕は思ってる。

最後に、あなたへ問いかけたい。

あなたは今、どんな立場にいますか?

AIに対して、どういう態度を取っていますか?

その態度は──「自分で選んだもの」だと、胸を張って言えますか?